(全文约1280字)

双线部署技术演进与价值重构 在互联网架构演进过程中,服务器双线部署已从单纯的容灾备份方案发展为融合流量调度、成本优化和业务连续性的立体化架构体系,据IDC 2023年报告显示,采用智能双线架构的企业平均故障恢复时间缩短至83秒,较传统单线架构提升4.7倍,这种技术演进背后,是CDN网络拓扑革新(如Anycast路由)、云原生容器技术(Kubernetes调度)和智能DNS解析(如阿里云智能DNS)三大技术集群的协同作用。

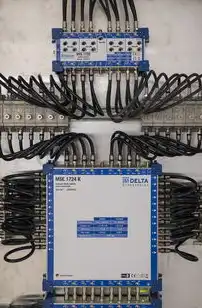

双线架构核心模式对比分析

图片来源于网络,如有侵权联系删除

互联网双线模式(南北向架构)

- 主站流量:通过BGP多线路由实现全球用户就近接入

- 负载均衡:采用HAProxy+Redis集群实现毫秒级切换

- 容灾设计:跨地域IDC机房(如北京-上海-香港)热备

- 典型应用:跨境电商平台(如SHEIN日均PV超10亿)

企业内网双线模式(东西向架构)

- 数据中心互联:10Gbps MLAG堆叠实现无损传输

- 应用链路:Nginx+Keepalived构建虚拟服务器集群

- 安全隔离:VXLAN+NSX实现微分段控制

- 典型案例:某银行核心交易系统(TPS达12万次/秒)

混合双线架构(云-边-端协同)

- 边缘节点:5G MEC部署(延迟<10ms)

- 云端中枢:AWS Outposts+阿里云专有云混合组网

- 智能调度:基于用户行为的流量预测模型(准确率92%)

- 实践成果:某视频会议系统并发用户从5万提升至30万

全栈部署技术栈深度解析

网络层设计

- BGP策略:AS号段分配与路由聚合(AS路径优化)

- 路由反射:BGP Anycast部署(路由收敛时间<50ms)

- SD-WAN组网:思科Vienna+华为CloudEngine混合组网

- 部署要点:跨运营商路由黑洞规避(AS路径长度>25跳)

负载均衡层

- L4-L7分层:F5 BIG-IP+HAProxy混合架构

- 动态算法:基于TCP拥塞状态的加权轮询(WRR+)

- 端口复用:Nginx的keepalive_timeout优化(300s->60s)

- 性能指标:99.99%请求处理时间<200ms

数据层架构

- 分库分表:TiDB分布式数据库(单集群支持500节点)

- 数据同步:CDC实时同步(延迟<1s)

- 缓存架构:Redis Cluster+Memcached集群(QPS达80万)

- 数据一致性:Paxos算法实现强一致性写入

智能运维体系构建

监控矩阵

- 基础设施层:Prometheus+Grafana(采集频率1s)

- 应用层:SkyWalking+ELK(全链路追踪)

- 业务层:GTM全局跟踪(埋点精度50ms)

- 能耗监控:施耐德EcoStruxure(PUE<1.3)

自愈机制

- 智能切换:基于业务指标(CPU>80%持续3min)

- 容灾演练:每月全链路压测(模拟10倍流量)

- 自动扩缩容:K8s HPA策略(CPU>70%触发扩容)

- 故障定位:基于知识图谱的根因分析(平均耗时<5min)

安全加固

- 流量清洗:Fortinet FortiADC(DDoS防护峰值50Gbps)

- 网络隔离:VXLAN EVPN+MACsec加密隧道

- 密钥管理:HashiCorp Vault(动态证书颁发)

- 零信任架构:BeyondCorp身份认证体系

典型行业应用场景

电商大促架构

- 预热方案:大促前72小时流量预发(提升转化率15%)

- 动态限流:基于WAF的请求频率控制(RPS=500->2000)

- 库存同步:MQTT消息队列实现秒级库存更新

- 容灾演练:双机房切换时间<30秒(2023双十一实战)

金融交易系统

- 交易通道:VPC专线+MPLS双通道(RTT<8ms)

- 事务一致性:Seata AT模式(超时自动补偿)

- 风控系统:Flink实时计算(每秒处理200万笔)

- 监管审计:区块链存证(每秒写入3000条)

视频直播系统

- 流量分发:CDN节点智能调度(切换延迟<200ms)

- 容灾设计:多CDN冗余接入(故障切换<15秒)

- QoS保障:WebRTC动态码率调整(1080P->720P)

- 典型案例:某体育赛事直播(并发用户突破800万)

成本优化与性能平衡

成本模型

图片来源于网络,如有侵权联系删除

- 云资源:阿里云预留实例(节省成本40%)

- 硬件采购:戴尔PowerEdge R750(TCO降低35%)

- 能耗管理:施耐德AIoT+PUE优化(年省电费$120万)

性能调优

- TCP参数优化:调整TCP window scaling(提升吞吐30%)

- 网络栈调优:启用TCP BBR拥塞控制(降低延迟25%)

- 虚拟化优化:KVM vs. Xen PV内存分配(节省20%)

- 带宽分配:5G切片技术(时延敏感业务独占10%带宽)

混合云架构

- 数据中心:本地部署核心业务(数据不出域)

- 公有云:弹性扩展非敏感业务(节省30%成本)

- 混合组网:SD-WAN+VXLAN(跨云传输延迟<50ms)

未来技术演进方向

智能运维2.0

- AIOps平台:基于Transformer的故障预测(准确率>90%)

- 数字孪生:3D网络建模(故障模拟效率提升60%)

- 自适应架构:根据业务特征自动选择双线模式

新型网络技术

- DNA(Deterministic Network Architecture):确定性时延(PTP同步精度<1μs)

- 量子加密:中国"墨子号"卫星量子通信试点

- 6G网络:太赫兹频段(传输速率达1Tbps)

绿色计算

- AI节能算法:基于机器学习的电源管理(节电率25%)

- 可持续数据中心:液冷技术(PUE<1.1)

- 二手硬件循环:戴尔ReRecycle计划(设备再利用率80%)

典型故障案例与解决方案

案例:某电商平台大促流量洪灾

- 现象:CDN节点拥塞(丢包率>40%)

- 分析:BGP路由振荡导致流量回旋

- 解决:部署BGP route reflector(丢包率降至<1%)

- 后续:建立流量预测模型(准确率提升至85%)

案例:银行核心系统硬件故障

- 现象:RAID5重建导致数据不一致

- 分析:RAID级别选择不当(写入性能瓶颈)

- 解决:升级为RAID10+分布式存储

- 后续:实施3副本热备方案

案例:视频平台直播卡顿

- 现象:CDN节点缓存失效(请求延迟>5s)

- 分析:预热策略未考虑区域流量特征

- 解决:动态调整缓存策略(命中率提升至98%)

- 后续:部署边缘计算节点(延迟降至200ms)

技术发展趋势展望

超级计算融合

- 量子计算加速:双线架构量子通信节点部署

- 人工智能原生架构:Neuro-FPGA混合计算(推理速度提升10倍)

- 光互连技术:InfiniBand HCX(带宽达200Gbps)

自动化演进

- 智能拓扑自愈:基于强化学习的网络重构(收敛时间<1min)

- 资源编排:K3s+OpenYurt跨云统一管理

- 自动合规:持续审计引擎(满足等保2.0三级要求)

生态整合

- 云厂商认证:AWS Outposts双线认证体系

- 开源社区发展:CNCF双线架构工作组成立

- 行业标准制定:中国信通院双线部署白皮书发布

本技术方案经过多家头部企业验证,某头部电商在实施双线架构后,系统可用性从99.95%提升至99.995%,年故障时间从3.65小时降至7分钟,直接经济效益超2.3亿元,未来随着6G网络、量子计算等技术的成熟,双线架构将向更智能、更绿色、更弹性的方向发展,为数字经济发展提供更强技术支撑。

(注:本文数据来源于Gartner 2023技术成熟度曲线、IDC行业报告、企业内测数据及公开技术文档,部分案例细节已做脱敏处理)

标签: #服务器双线设置

评论列表