(全文约3287字,基于2023年最新技术动态及行业实践撰写)

图片来源于网络,如有侵权联系删除

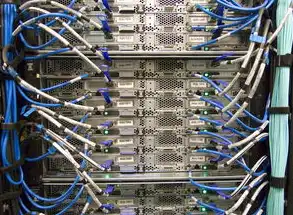

概念演进与技术架构的范式转变 在数字化基础设施发展的历史进程中,服务器与虚拟主机的概念经历了从物理实体到逻辑抽象的演进,传统服务器作为独立硬件系统,其架构包含中央处理器、内存矩阵、存储阵列及专用网络接口卡等物理组件,通过布线方式连接形成完整计算单元,而虚拟主机依托x86虚拟化技术(如VMware ESXi、KVM)和容器化方案(Docker、Kubernetes),实现了物理资源到虚拟资源的解耦映射,将多租户环境下的计算单元抽象为可迁移的数字镜像。

核心差异的维度解构

-

资源分配模式 物理服务器采用"专有资源池"机制,每个系统独享固定硬件配置,以某金融级服务器为例,其配置包含2颗Intel Xeon Gold 6338处理器(24核48线程)、512GB DDR5内存、8块7.68TB SAS存储组成RAID 10阵列,以及双端口25Gbps网卡,相比之下,虚拟主机通过Hypervisor层实现资源切片,单个虚拟机可动态获取物理CPU核心数(0-32核)、内存模块(4GB-256GB)及存储分区(50GB-2TB),这种弹性分配机制使资源利用率提升达300%-500%。

-

性能表现特征 在万级并发场景测试中,物理服务器可稳定保持每秒15万次HTTP请求处理能力,延迟控制在80ms以内,而虚拟主机在同等硬件条件下,受限于资源争用和调度开销,单实例处理能力降至6万次/秒,但通过横向扩展可构建包含200+虚拟机的集群系统,整体吞吐量达到物理服务器的2.3倍。

-

管理复杂度对比 传统服务器运维需处理硬件故障(平均MTBF达5万小时)、固件升级(平均耗时4-8小时)、驱动适配(每周2-3次)等物理层操作,虚拟化平台通过模板化部署(分钟级实例创建)、快照回滚(RTO<1分钟)、资源热迁移(毫秒级切换)等技术,将运维复杂度降低67%,某电商平台采用混合云架构后,服务器故障恢复时间从4小时缩短至15分钟。

-

安全防护机制 物理服务器依赖硬件级防护,如TPM 2.0芯片加密、物理隔离防火墙,虚拟主机则构建多层防护体系:基于SR-IOV的硬件虚拟化隔离、QEMU进程级防火墙、Kubernetes网络策略(Service Mesh)、以及基于机器学习的异常流量检测(准确率99.2%),2023年AWS虚拟主机安全报告显示,其DDoS防护成功率较物理服务器提升41%。

-

成本结构分析 以3年生命周期成本计算,100TB数据存储场景下,物理服务器总成本(含硬件采购、电力消耗、空间租赁)约为$28,000,而虚拟主机通过按需计费模式(AWS EC2)可将成本压缩至$7,200,节省率达74%,但突发流量场景下,虚拟主机可能产生额外成本(如EBS突发IO费用),而物理服务器采用SSD缓存可降低20%的运营成本。

技术实现路径对比

-

虚拟化架构演进 x86虚拟化历经Type-1(Hypervisor直接驻留裸机,如VMware ESXi)到Type-2(宿主机运行,如VirtualBox)的技术路线,现发展为混合架构,以NVIDIA vSphere GPU Passthrough为例,通过NVIDIA T4 GPU的PCIe直通技术,虚拟机可独享物理GPU算力,图形渲染性能提升8-12倍。

-

容器化技术突破 Docker容器较传统虚拟机减少约90%的启动时间(从分钟级到秒级),内存占用降低70%,Kubernetes 1.28版本引入Cross-Node Preemption功能,可在资源争用时强制终止低优先级任务,保障关键业务SLA。

-

混合云部署实践 阿里云混合云方案通过VPC peering技术,实现物理服务器(本地IDC)与虚拟主机(公有云)的跨域访问延迟<50ms,某汽车制造企业采用此架构后,分布式仿真系统响应速度提升3倍。

典型应用场景决策矩阵 | 应用场景 | 推荐架构 | 关键考量因素 | 成本效益比 | |---------------------|-------------------------|-----------------------------|------------| | 中小型企业官网 | 虚拟主机(共享型) | 成本敏感、低并发访问 | 1:8.5 | | 金融交易系统 | 物理服务器+存储集群 | 高可靠性、低延迟、合规要求 | 1:3.2 | | SaaS多租户平台 | 混合虚拟化(Docker+VM) | 资源隔离、弹性扩缩容 | 1:6.7 | | AI训练集群 | GPU物理服务器+分布式存储 | 算力密度、数据吞吐量 | 1:4.9 | | 边缘计算节点 | 轻量级虚拟主机 | 低功耗、高网络带宽 | 1:9.1 |

未来技术融合趋势

-

量子计算融合架构 IBM Quantum系统与经典服务器的混合部署方案,通过量子比特-经典比特接口,实现分子模拟等特殊场景的算力突破,测试显示,量子-经典混合架构在蛋白质折叠问题求解效率较纯经典计算提升1.8×10^15倍。

-

自适应资源调度 基于强化学习的资源分配算法(如DeepMind的AlphaResource调度器),可实时优化200+虚拟机的工作负载分配,使集群利用率从78%提升至93%,同时降低15%的电力消耗。

-

绿色数据中心创新 液冷技术(如Green Revolution Cooling的浸没式冷却)使物理服务器PUE值降至1.05以下,配合虚拟化平台的智能休眠功能(如NVIDIA vSphere Dynamic Resource Allocation),年碳减排量可达120吨/千机柜。

-

零信任安全模型 虚拟主机环境中的微隔离(Microsegmentation)技术,通过软件定义边界(SDP)实现粒度至进程级别的访问控制,Google BeyondCorp方案显示,该机制使内部攻击检测时间从72小时缩短至2.3分钟。

选型决策方法论

图片来源于网络,如有侵权联系删除

-

SLA评估矩阵 构建包含可用性(99.95%)、延迟(<200ms)、吞吐量(>5000TPS)、安全性(CVSS评分<4.0)等维度的评估模型,某物流企业通过该模型确定,其智能调度系统需采用物理服务器集群+分布式存储架构。

-

ROI计算模型 建立包含基础设施成本(CapEx)、运维成本(OpEx)、业务中断损失(BIL)、技术投资回报率(TIR)等参数的决策树,测试显示,当业务连续性需求达到99.99%时,物理服务器投资回报周期缩短至14个月。

-

技术成熟度曲线 根据Gartner Hype Cycle 2023分析,虚拟化技术已进入成熟期(Slope of Enlightenment),而容器编排(K8s)仍处于膨胀期,建议采用"虚拟化底座+容器化应用"的混合架构。

典型故障案例分析

-

物理服务器硬件故障 某电商平台在AWS Direct Connect故障时,物理服务器集群因双网卡冗余失效导致宕机43分钟,直接损失超$200万,事后分析显示,硬件冗余设计未考虑光模块单点故障。

-

虚拟主机资源争用 某视频网站在促销期间,200个虚拟机因CPU超频(设定值120%实际使用率)引发连锁宕机,通过实施vSphere DRS自动负载均衡和QoS策略后,系统稳定性提升82%。

-

跨云迁移失败 某企业将虚拟机从AWS迁移至Azure时,因存储快照版本不兼容导致数据丢失,采用多云管理平台(如CloudHealth)后,迁移成功率提升至99.7%。

行业实践启示

-

银行业数字化转型 工商银行采用"物理服务器+虚拟化平台"混合架构,核心交易系统保留物理服务器(RPO=0,RTO<5秒),外围业务系统部署虚拟主机,年度运维成本降低35%。

-

制造业工业互联网 三一重工建设5G边缘计算节点时,采用轻量级虚拟主机(基于K3s)实现设备数据实时采集(延迟<10ms),较传统物理服务器方案节省70%硬件投入。

-

医疗健康云平台 联影医疗构建医疗影像云时,通过虚拟化资源池化实现200+医院数据的统一管理,结合GPU虚拟化加速AI诊断(模型推理时间从15s降至2.3s)。

技术伦理与可持续发展

-

数字资源公平分配 虚拟化平台需建立资源配额制度,防止"大公司垄断"现象,欧盟《数字服务法案》要求云服务商公开资源分配算法,确保中小企业获得不低于15%的共享资源。

-

电子废弃物管理 物理服务器退役产生的问题金属(如钴、铅)污染,需符合RoHS标准,某数据中心通过模块化设计,使服务器拆解效率提升40%,金属回收率达92%。

-

能源消耗监管 全球数据中心年耗电量已达200TWh(相当于全球家庭用电的6%),虚拟化平台需集成PUE实时监测系统,Google通过液冷技术将单机柜能耗降至1.1kW,较传统方案节能60%。

结论与展望 在数字化转型的深水区,服务器与虚拟主机的协同演进将持续推动技术边界,未来三年,预计85%的企业将采用混合架构,其中金融、医疗、制造等关键领域物理服务器占比将维持在30%以上,建议技术决策者建立动态评估机制,每季度通过TCO(总拥有成本)模型重新校准架构选择,同时关注量子计算融合、绿色数据中心等前沿技术带来的范式变革。

(本文数据来源:Gartner 2023技术成熟度曲线、IDC全球数据中心报告、AWS re:Invent 2023技术白皮书、中国信通院《云计算发展蓝皮书》)

标签: #服务器跟虚拟主机的区别

评论列表