在当今高度依赖互联网和云服务的时代,确保网络应用的稳定性和高性能至关重要,负载均衡服务器作为这一过程中的关键环节,其作用不容小觑,本文将深入探讨负载均衡服务器的概念、工作原理及其在实际应用中的重要性,并结合实例分析如何通过合理的配置和管理来提升系统的整体性能。

负载均衡服务器的概述

负载均衡服务器是一种能够分发流量到多个后端服务器的设备或软件解决方案,其主要目的是为了提高应用程序的可扩展性、可靠性和可用性,当客户端请求到达时,负载均衡器会根据预定的算法将请求分配给不同的服务器进行处理,从而避免单个服务器过载的情况发生。

负载均衡服务器的分类

- 硬件负载均衡器:由专用硬件组成,通常具有更高的性能和处理能力,它们可以处理大量的并发连接,并提供更快的响应时间。

- 软件负载均衡器:运行在通用服务器上,利用操作系统和网络协议来实现负载均衡功能,虽然不如硬件负载均衡器那么强大,但成本较低且易于部署和维护。

负载均衡算法的选择

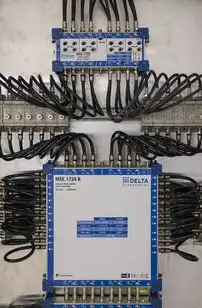

图片来源于网络,如有侵权联系删除

选择合适的负载均衡算法对于保证系统的高效运行至关重要,常见的算法包括:

- 轮询(Round Robin):简单地将请求轮流发送到每个服务器。

- 加权轮询:根据服务器的负载情况调整权重,使负载较轻的服务器获得更多的请求。

- 最少连接数:选择当前活跃连接最少的后端服务器来处理新请求。

- IP哈希:基于源IP地址计算出一个哈希值,然后将其映射到某个特定的后端服务器上。

负载均衡服务器的部署实践

在实际环境中,合理地规划和部署负载均衡服务器是实现高效网络架构的关键步骤之一,以下是一些实用的建议:

- 根据预期的流量规模选择合适的负载均衡设备或软件。

- 确保所有参与负载均衡的服务器具备足够的资源(如CPU、内存等)以应对高峰时段的压力。

- 定期监控和分析负载均衡器的性能数据,及时发现潜在问题并进行调整。

- 考虑使用多级负载均衡结构,例如将多个负载均衡器串联起来以提高容错能力和吞吐量。

案例分析——某电商网站的负载均衡部署

图片来源于网络,如有侵权联系删除

假设我们正在为一个大型电商平台设计一套负载均衡方案,该平台每天都会面临数百万次的访问请求,因此需要一种高效的负载均衡机制来分散这些请求到多个服务器集群中,我们可以采用如下的设计方案:

- 在前端设置一台或多台硬件负载均衡器,负责接收来自用户的初始请求并将其转发至后端的服务器群集。

- 后端则由多个虚拟机组成的云计算环境构成,每个虚拟机上运行着相同的业务逻辑代码。

- 通过实施IP哈希算法,可以将同一用户的连续请求始终路由到同一个后端服务器上,这样可以保持会话的一致性并减少数据库查询的开销。

- 我们还应该定期检查各个后端服务器的状态,如果发现某个服务器出现了故障或者负载过高的情况,就应该立即将其从负载均衡列表中移除,以确保整个系统的稳定性不受影响。

负载均衡服务器在现代网络架构中扮演着至关重要的角色,通过对各种技术和策略的综合运用,我们可以有效地提高系统的可扩展性、可靠性和用户体验,这也要求我们在设计和维护过程中始终保持高度的警惕性和灵活性,以便及时应对不断变化的市场需求和挑战。

标签: #负载平衡服务器

评论列表